5еҲҶйҗҳдәҶи§Ј Cloudflare AIйҳІзҒ«зүҶ ( Firewall for AI ) еҰӮдҪ•йҳІзҰҰиіҮж–ҷеӨ–жөҒ

Cloudflare жҳҜйҰ–жү№жҺЁеҮәдёҖеҘ—е·Ҙе…·дҫҶдҝқиӯ· AI жҮүз”ЁзЁӢејҸзҡ„е®үе…ЁжҸҗдҫӣиҖ…д№ӢдёҖгҖӮдҪҝз”Ё Firewall for AIпјҢе®ўжҲ¶еҸҜд»ҘжҺ§еҲ¶е“ӘдәӣжҸҗзӨәи©һе’Ңи«ӢжұӮиғҪеӨ еҲ°йҒ”е…¶иӘһиЁҖжЁЎеһӢпјҢеҫһиҖҢйҷҚдҪҺжҝ«з”Ёе’ҢиіҮж–ҷеӨ–жөҒзҡ„йўЁйҡӘ

Cloudflare жңҖиҝ‘е®Јеёғе°ҮжҺЁеҮә Firewall for AIгҖӮйҖҷжқұиҘҝе°ұеғҸжҳҜдёҖеҖӢи¶…зҙҡдҝқй‘ЈпјҢе°Ҳй–Җдҝқиӯ·йӮЈдәӣдҪҝз”ЁеӨ§еһӢиӘһиЁҖжЁЎеһӢ (LLM) зҡ„жҮүз”ЁзЁӢејҸгҖӮLLM жҳҜйӮЈдәӣз”ЁиҮӘ然иӘһиЁҖж“ҚдҪңзҡ„ AI жЁЎеһӢпјҢдёҚеғҸеӮізөұжҮүз”ЁзЁӢејҸйӮЈйәјзӣҙжҺҘгҖӮйҖҷеҖӢдҝқй‘Јзҡ„зӣ®зҡ„жҳҜеңЁдёҚиүҜиЎҢзӮәеҲ°йҒ”жЁЎеһӢд№ӢеүҚе…ҲиӯҳеҲҘе®ғеҖ‘гҖӮз°Ўе–®дҫҶиӘӘпјҢе°ұжҳҜи®“дҪ зҡ„ AI жҮүз”ЁзЁӢејҸжӣҙе®үе…ЁпјҢдёҚиў«жғЎж„ҸиҖ…жҗһдәӮгҖӮ

и®“жҲ‘еҖ‘дҫҶзңӢзңӢйҖҷеҖӢ Firewall for AI зҡ„дёҖдәӣзІҫиҸҜйҮҚй»һпјҡ

1. д»ҖйәјжҳҜ Firewall for AIпјҹ

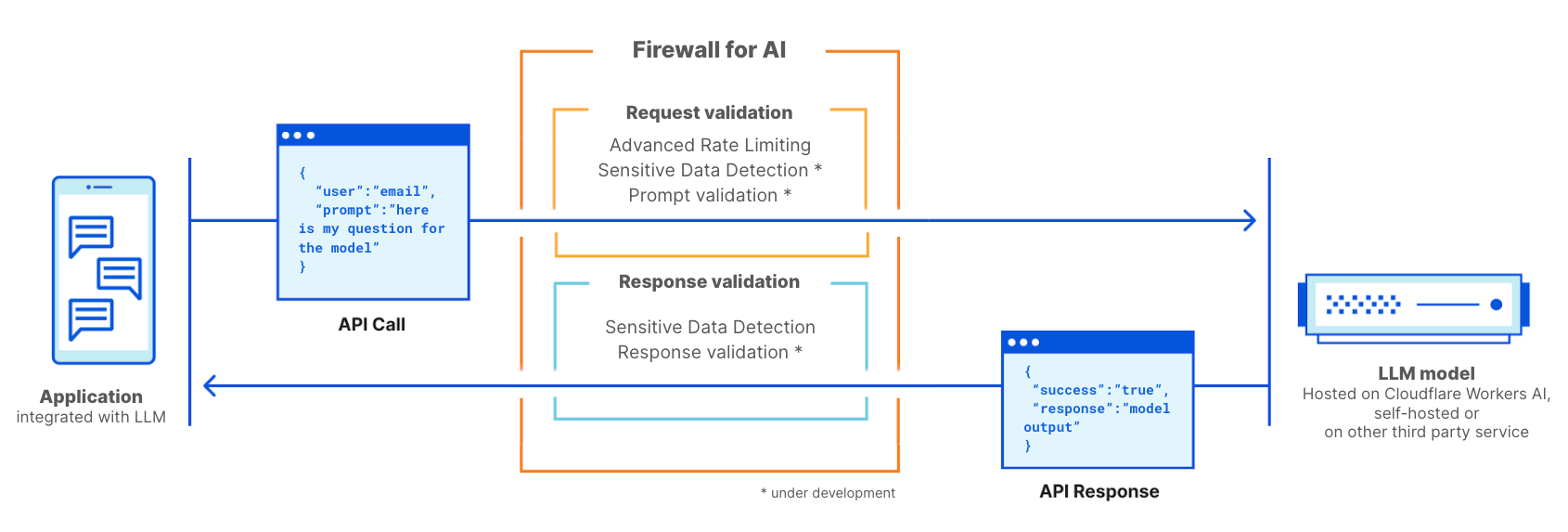

е®ғжҳҜдёҖеҖӢйҖІйҡҺзҡ„ Web жҮүз”ЁзЁӢејҸйҳІзҒ«зүҶпјҢе°ҲзӮәдҪҝз”Ё LLM зҡ„жҮүз”ЁзЁӢејҸйҮҸиә«е®ҡиЈҪгҖӮе®ғзҡ„е·ҘдҪңж–№ејҸе°ұеғҸдёҖеҖӢдҝқй‘ЈпјҢз«ҷеңЁ LLM жҮүз”ЁзЁӢејҸеүҚйқўпјҢжҺғжҸҸжҜҸеҖӢдҪҝз”ЁиҖ…зҡ„и«ӢжұӮпјҢд»ҘиӯҳеҲҘеҸҜиғҪзҡ„ж”»ж“Ҡзү№еҫөгҖӮ

LLM иҲҮеӮізөұжҮүз”ЁзЁӢејҸзҡ„дёҚеҗҢпјҡ

- дҪҝз”ЁиҖ…дә’еӢ•ж–№ејҸпјҡLLM зҡ„ж“ҚдҪңжҳҜеҹәж–јиҮӘ然иӘһиЁҖпјҢиҲҮеӮізөұжҮүз”ЁзЁӢејҸзҡ„зўәе®ҡжҖ§ж“ҚдҪңдёҚеҗҢгҖӮйҖҷдҪҝеҫ—иӯҳеҲҘжңүе•ҸйЎҢзҡ„и«ӢжұӮжҜ”жҜ”е°Қж”»ж“Ҡзү№еҫөжӣҙеӣ°йӣЈгҖӮ

- жҺ§еҲ¶е№ійқўиҲҮиіҮж–ҷдә’еӢ•ж–№ејҸпјҡLLM зҡ„иЁ“з·ҙиіҮж–ҷжҲҗзӮәжЁЎеһӢжң¬иә«зҡ„дёҖйғЁеҲҶпјҢйӣЈд»ҘжҺ§еҲ¶жҮүз”ЁзЁӢејҸеҰӮдҪ•е°Үи©ІиіҮж–ҷдҪңзӮәдҪҝз”ЁиҖ…жҸҗзӨәи©һзҡ„зөҗжһңеҲҶдә«еҮәеҺ»гҖӮ

2. LLM еҚҒеӨ§жјҸжҙһпјҡ

OWASP еҹәйҮ‘жңғзҷјдҪҲдәҶ LLM еҚҒеӨ§жјҸжҙһжё…е–®пјҢйҖҷеҖӢжё…е–®жҸҗдҫӣдәҶдҝқиӯ·иӘһиЁҖжЁЎеһӢзҡ„жңүз”ЁжЎҶжһ¶гҖӮе…¶дёӯдёҖдәӣеЁҒи„…йЎһдјјж–ј OWASP зҡ„ Web жҮүз”ЁзЁӢејҸеҚҒеӨ§жјҸжҙһпјҢеҸҰдёҖдәӣеүҮжҳҜиӘһиЁҖжЁЎеһӢжүҖзү№жңүзҡ„гҖӮйҖҸйҒҺжҺЎз”ЁеғҸ Cloudflare Firewall for AI д№ӢйЎһзҡ„д»ЈзҗҶе®үе…Ёи§Јжұәж–№жЎҲпјҢеҸҜд»Ҙз·©и§ЈйҖҷдәӣжјҸжҙһгҖӮ

йҖҷеҖӢйҳІзҒ«зүҶзү№еҲҘй—ңжіЁдёүзЁ®жЁЎеһӢж”»ж“ҠпјҡжҸҗзӨәи©һжіЁе…ҘгҖҒжЁЎеһӢжӢ’зө•жңҚеӢҷпјҢд»ҘеҸҠж•Ҹж„ҹиіҮиЁҠжҙ©жјҸгҖӮе®ғзҡ„йғЁзҪІж–№ејҸиҲҮеӮізөұз¶Ій ҒжҮүз”ЁйҳІзҒ«зүҶзӣёдјјпјҢжҜҸеҖӢеё¶жңүеӨ§еһӢиӘһиЁҖжЁЎеһӢжҸҗзӨәи©һзҡ„ API и«ӢжұӮйғҪжңғ經йҒҺйҳІзҒ«зүҶжҺғжҸҸпјҢд»ҘеҒөжё¬еҸҜиғҪзҡ„ж”»ж“ҠжЁЎејҸе’Ңзү№еҫөгҖӮ

3. LLM йғЁзҪІж–№жі•пјҡ

- е…§йғЁ LLMпјҡе…¬еҸёй–Ӣзҷј LLM дҫҶж”ҜжҸҙе“Ўе·Ҙзҡ„ж—Ҙеёёд»»еӢҷгҖӮйҖҷдәӣиў«иҰ–зӮәе…¬еҸёиіҮз”ўпјҢдёҚеҫ—иў«йқһе“Ўе·ҘеӯҳеҸ–гҖӮдҫӢеҰӮпјҢдҪҝз”ЁйҠ·е”®иіҮж–ҷе’Ңе®ўжҲ¶дә’еӢ•йҖІиЎҢиЁ“з·ҙдёҰз”Ёж–јз”ўз”ҹе®ҡеҲ¶еҢ–жҸҗжЎҲзҡ„ AI co-pilotпјҢжҲ–иҖ…дҪҝз”Ёе…§йғЁзҹҘиӯҳеә«йҖІиЎҢиЁ“з·ҙдё”еҸҜдҫӣе·ҘзЁӢеё«жҹҘи©ўзҡ„ LLMгҖӮ

- е…¬з”Ё LLMпјҡйҖҷдәӣжҳҜеҸҜд»ҘеңЁе…¬еҸёйӮҠз•Ңд№ӢеӨ–еӯҳеҸ–зҡ„ LLMгҖӮйҖҷдәӣи§Јжұәж–№жЎҲйҖҡеёёжңүд»»дҪ•дәәйғҪеҸҜд»ҘдҪҝз”Ёзҡ„е…ҚиІ»зүҲжң¬пјҢиҖҢдё”е®ғеҖ‘йҖҡеёёжҺҘеҸ—йҒҺдёҖиҲ¬жҲ–е…¬е…ұзҹҘиӯҳзҡ„иЁ“з·ҙгҖӮзҜ„дҫӢеҢ…жӢ¬ OpenAI зҡ„ GPT жҲ– Anthropic зҡ„ ClaudeгҖӮ

- з”ўе“Ғ LLMпјҡеҫһе…¬еҸёзҡ„и§’еәҰдҫҶзңӢпјҢLLM еҸҜд»ҘжҲҗзӮәжҸҗдҫӣзөҰе®ўжҲ¶зҡ„з”ўе“ҒжҲ–жңҚеӢҷзҡ„дёҖйғЁеҲҶгҖӮйҖҷдәӣйҖҡеёёжҳҜе®ҡеҲ¶зҡ„иҮӘжүҳз®Ўи§Јжұәж–№жЎҲпјҢеҸҜд»ҘдҪңзӮәиҲҮе…¬еҸёиіҮжәҗдә’еӢ•зҡ„е·Ҙе…·гҖӮдҫӢеҰӮе®ўжҲ¶ж”ҜжҸҙиҒҠеӨ©ж©ҹеҷЁдәәжҲ– Cloudflare AI еҠ©зҗҶгҖӮ

з„Ўи«–е“ӘзЁ®йғЁзҪІж–№жі•пјҢйғҪйңҖиҰҒдҝқиӯ·жЁЎеһӢе…ҚйҒӯжҝ«з”ЁпјҢдҝқиӯ·жЁЎеһӢдёӯе„Іеӯҳзҡ„е°ҲжңүиіҮж–ҷпјҢд»ҘеҸҠдҝқиӯ·зөӮз«ҜдҪҝз”ЁиҖ…е…Қж–јжҺҘи§ёйҢҜиӘӨиЁҠжҒҜжҲ–дёҚ當內容гҖӮ

4. Firewall for AIзҡ„йҒӢдҪңж–№ејҸпјҡ

е®ғйғЁзҪІеңЁ LLM жҮүз”ЁзЁӢејҸеүҚж–№пјҢдёҰжҺғжҸҸжҜҸеҖӢи«ӢжұӮд»ҘиӯҳеҲҘж”»ж“Ҡзү№еҫөгҖӮйҖҸйҒҺйҷҗйҖҹеҺҹеүҮпјҢеҸҜд»ҘжҺ§еҲ¶е–®дёҖе·ҘдҪңйҡҺж®өзҡ„и«ӢжұӮйҖҹзҺҮпјҢжёӣиј•е·ЁжөҒйҮҸж”»ж“Ҡзҡ„йўЁйҡӘгҖӮ

5. еҰӮдҪ•дҪҝз”Ё Firewall for AIпјҹиӘ°жңүиіҮж јзҚІеҫ—и©Із”ўе“Ғпјҹ

дҪҝз”ЁжҮүз”ЁзЁӢејҸе®үе…ЁжҖ§йҖІйҡҺз”ўе“Ғзҡ„дјҒжҘӯж–№жЎҲе®ўжҲ¶еҸҜд»Ҙз«ӢеҚій–Ӣе§ӢдҪҝз”ЁйҖІйҡҺйҷҗйҖҹе’Ңж•Ҹж„ҹиіҮж–ҷеҒөжё¬пјҲеңЁеӣһжҮүйҡҺж®өпјүгҖӮйҖҷе…©зЁ®з”ўе“ҒйғҪеҸҜд»ҘеңЁ Cloudflare е„ҖиЎЁжқҝзҡ„ WAF йғЁеҲҶдёӯжүҫеҲ°гҖӮFirewall for AI зҡ„жҸҗзӨәи©һй©—иӯүеҠҹиғҪзӣ®еүҚжӯЈеңЁй–ӢзҷјдёӯпјҢжё¬и©ҰзүҲе°ҮеңЁжңӘдҫҶе№ҫеҖӢжңҲе…§еҗ‘жүҖжңү Workers AI дҪҝз”ЁиҖ…зҷјдҪҲгҖӮиЁ»еҶҠеҠ е…ҘзӯүеҖҷеҗҚе–®пјҢдёҰеңЁи©ІеҠҹиғҪеҸҜз”ЁжҷӮ收еҲ°йҖҡзҹҘгҖӮ

CloudflareжҳҜжӮЁзҡ„ AI е®үе…Ёе®Ҳиӯ·иҖ…пјҢжҺҢжҺ§иіҮиЁҠпјҢдҝқиӯ·жңӘдҫҶ

Cloudflare жҳҜйҰ–жү№жҺЁеҮәдёҖеҘ—е·Ҙе…·дҫҶдҝқиӯ· AI жҮүз”ЁзЁӢејҸзҡ„е®үе…ЁжҸҗдҫӣиҖ…д№ӢдёҖгҖӮдҪҝз”Ё Firewall for AIпјҢе®ўжҲ¶еҸҜд»ҘжҺ§еҲ¶е“ӘдәӣжҸҗзӨәи©һе’Ңи«ӢжұӮиғҪеӨ еҲ°йҒ”е…¶иӘһиЁҖжЁЎеһӢпјҢеҫһиҖҢйҷҚдҪҺжҝ«з”Ёе’ҢиіҮж–ҷеӨ–жөҒзҡ„йўЁйҡӘгҖӮи«Ӣз№јзәҢй—ңжіЁпјҢд»Ҙзһӯи§Јжңүй—ң AI жҮүз”ЁзЁӢејҸе®үе…ЁжҖ§еҰӮдҪ•жј”и®Ҡзҡ„жӣҙеӨҡиіҮиЁҠгҖӮеҰӮжһңжӮЁе°Қж–ј Clouflare иҲҮ AI зӣёй—ңжҮүз”ЁжғійҖІдёҖжӯҘзһӯи§ЈпјҢжӯЎиҝҺиҲҮжЁӮйӣІз·ҡдёҠжҙҪи©ўпјҢжҲ‘еҖ‘жңғзӣЎеҝ«еӣһиҰҶжӮЁпјҒ

(еҰӮж¬ІзҖҸиҰҪи©ізҙ°еҺҹж–ҮпјҢи«ӢиҰӢжӯӨпјҡ Cloudflare е®ЈдҪҲжҺЁеҮә Firewall for AI )