з”ҹжҲҗејҸ AI иЎқж“ҠдјҒжҘӯиіҮе®үжҖҺйәјиҫҰ? йҒ©з”Ё AI жңҚеӢҷзҡ„ Zero Trust е®үе…ЁжҖ§

е°Қж–ј ChatGPT зӯү AI е·Ҙе…·зҡ„еҮәзҸҫпјҢдёҖдәӣеӣһжҮүжҳҜеҳ—и©Ұеҫ№еә•зҰҒжӯўи©ІжңҚеӢҷпјҢз„Ўи«–жҳҜеңЁдјҒжҘӯеұӨйқўйӮ„жҳҜеңЁж•ҙеҖӢеңӢ家гҖӮCloudflareиӘҚзӮәдёҚеҝ…йҖҷжЁЈеҒҡгҖӮCloudflare One зҡ„зӣ®жЁҷжҳҜпјҢз„Ўи«–е·Ҙе…·дҪҚж–јдҪ•иҷ•пјҢйғҪи®“жӮЁиғҪеӨ е®үе…Ёең°дҪҝз”ЁжүҖйңҖзҡ„е·Ҙе…·пјҢиҖҢдёҚжңғеҪұйҹҝж•ҲиғҪгҖӮе°Қж–ј Cloudflare One дёӯзҡ„ Zero Trust з”ўе“Ғзҡ„зҸҫжңүдҪҝз”ЁиҖ…дҫҶиӘӘпјҢжң¬ж–Үеұ•зӨәзҡ„еҠҹиғҪжңғи®“дәәж„ҹиҰәеҫҲзҶҹжӮүгҖӮ

Cloudflare One зҡ„дёҖзі»еҲ—е·Ҙе…·еҸҜ幫еҠ©жӮЁзҡ„еңҳйҡҠе®үе…Ёең°дҪҝз”Ё AI жңҚеӢҷ

Cloudflare One жҳҜдёҖеҖӢи®“жӮЁеңҳйҡҠеҸҜд»Ҙе®үе…Ёең°дҪҝз”Ёз¶Іи·ҜдёҠжңҖеҘҪзҡ„е·Ҙе…·зҡ„е№іеҸ°пјҢдёҚжңғйҒҮеҲ°з®ЎзҗҶйӣЈйЎҢжҲ–ж•ҲиғҪжҢ‘жҲ°гҖӮиҝ‘жңҹжҺЁеҮәCloudflare One for AI ж–°еҠҹиғҪпјҢи®“жӮЁзҡ„еңҳйҡҠеҸҜд»Ҙз”ЁжңҖж–°зҡ„ AI жңҚеӢҷпјҢеҗҢжҷӮдҝқжҢҒ Zero Trust е®үе…ЁзӢҖж…ӢгҖӮ

еӨ§еһӢиӘһиЁҖжЁЎеһӢпјҢжӣҙеӨ§зҡ„е®үе…ЁжҢ‘жҲ°

е’Ң OpenAI зҡ„ GPT жҲ– Google зҡ„ Bard дёҖжЁЈпјҢеӨ§еһӢиӘһиЁҖжЁЎеһӢ (LLM) еҢ…еҗ«дёҖеҖӢзҘһ經網и·ҜпјҢи©ІзҘһ經網и·ҜйҮқе°ҚдёҖзө„иіҮж–ҷйҖІиЎҢиЁ“з·ҙпјҢд»Ҙж №ж“ҡжҸҗзӨәй җжё¬е’Ңз”ўз”ҹж–Үеӯ—гҖӮдҪҝз”ЁиҖ…еҸҜд»ҘжҸҗеҮәе•ҸйЎҢгҖҒеҫөжұӮеҸҚйҘӢпјҢдёҰдҫқйқ и©ІжңҚеӢҷдҫҶеүөдҪңеҫһи©©жӯҢеҲ° Cloudflare Workers жҮүз”ЁзЁӢејҸзӯүијёеҮәгҖӮ

йҖҷдәӣе·Ҙе…·е°ұеғҸзҸҫеҜҰз”ҹжҙ»дёӯзҡ„дёҖдәӣеҖӢдәәе°Қи©ұдёҖжЁЈпјҢйҒҺеәҰеҲҶдә«еҸҜиғҪжңғжҲҗзӮәйҖҷдәӣ AI жңҚеӢҷзҡ„еҡҙйҮҚе•ҸйЎҢгҖӮйҡЁи‘— LLM жЁЎеһӢзҡ„дҪҝз”ЁжЎҲдҫӢйЎһеһӢ蓬еӢғзҷјеұ•пјҢйҖҷзЁ®йўЁйҡӘд№ҹжңғжҲҗеҖҚеўһеҠ гҖӮйҖҷдәӣе·Ҙе…·еҸҜд»Ҙ幫еҠ©й–Ӣзҷјдәәе“Ўи§Јжұәеӣ°йӣЈзҡ„з·ЁзўјжҢ‘жҲ°пјҢжҲ–幫еҠ©иіҮиЁҠе·ҘдҪңиҖ…еҫһдёҖеңҳзіҹзҡ„зӯҶиЁҳдёӯе»әз«Ӣз°ЎжҪ”зҡ„е ұе‘ҠгҖӮйӣ–然еҫҲжңү幫еҠ©пјҢдҪҶијёе…ҘжҸҗзӨәзҡ„жҜҸеҖӢијёе…ҘйғҪжңғжҲҗзӮәдёҚеҸ—зө„з№”жҺ§еҲ¶зҡ„дёҖж®өиіҮж–ҷгҖӮеӣ жӯӨпјҢAIжңҚеӢҷеӢўдёҚеҸҜжӘ”пјҢдҪҶеҚ»жҲҗзӮәиіҮе®үдёҠзҡ„йҡұжҶӮгҖӮ

дҪҝз”Ёд»»дҪ•ж–№жЎҲзҡ„ Cloudflare One е®ўжҲ¶зҸҫеңЁйғҪеҸҜд»ҘжҹҘзңӢ AI зҡ„дҪҝз”Ёжғ…жіҒгҖӮжӮЁзҡ„ IT йғЁй–ҖеҸҜд»ҘйғЁзҪІ Cloudflare Gateway дёҰиў«еӢ•и§ҖеҜҹжңүеӨҡе°‘дҪҝз”ЁиҖ…жӯЈеңЁйҒёж“Үе“ӘдәӣжңҚеӢҷпјҢд»ҘжӯӨй–Ӣе§Ӣзўәе®ҡдјҒжҘӯжҺҲж¬ҠиЁҲз•«зҡ„зҜ„еңҚгҖӮ

з®ЎзҗҶе“Ўд№ҹеҸҜд»ҘдёҖйҚөе°ҒйҺ–е°ҚйҖҷдәӣжңҚеӢҷзҡ„дҪҝз”ЁпјҢдҪҶйҖҷдёҰдёҚжҳҜжҲ‘еҖ‘зӣ®еүҚзҡ„зӣ®жЁҷгҖӮеҰӮжһңжӮЁйҒёж“Ү ChatGPT дҪңзӮәж ёеҮҶзҡ„жЁЎеһӢпјҢдёҰдё”жғіиҰҒзўәдҝқеңҳйҡҠжҲҗе“ЎдёҚжңғз№јзәҢдҪҝз”Ёжӣҝд»Је·Ҙе…·пјҢжӮЁеҸҜиғҪжңғжғіиҰҒдҪҝз”ЁжӯӨеҠҹиғҪпјҢдҪҶжҲ‘еҖ‘еёҢжңӣжӮЁдёҚиҰҒзӣҙжҺҘе°ҒйҺ–жүҖжңүйҖҷдәӣжңҚеӢҷгҖӮ

Cloudflare зҡ„йҰ–иҰҒд»»еӢҷжҳҜи®“жӮЁиғҪеӨ е®үе…Ёең°дҪҝз”ЁйҖҷдәӣе·Ҙе…·гҖӮ

жҺ§еҲ¶ API еӯҳеҸ–

當жҲ‘еҖ‘зҡ„еңҳйҡҠй–Ӣе§Ӣеҳ—и©Ұ OpenAI зҡ„ ChatGPT жңҚеӢҷжҷӮпјҢжҲ‘еҖ‘е°Қе®ғе°Қ Cloudflare зҡ„зһӯи§Јж„ҹеҲ°й©ҡиЁқгҖӮжҲ‘еҖ‘иҰҒжұӮ ChatGPT дҪҝз”Ё Cloudflare Workers е»әз«ӢжҮүз”ЁзЁӢејҸжҲ–жҢҮе°ҺжҲ‘еҖ‘иЁӯе®ҡ Cloudflare Access еҺҹеүҮпјҢеңЁеӨ§еӨҡж•ёжғ…жіҒдёӢпјҢзөҗжһңжҳҜжә–зўәдё”жңүз”Ёзҡ„гҖӮ

еңЁжҹҗдәӣжғ…жіҒдёӢпјҢзөҗжһңдёҰдёҚзӣЎеҰӮдәәж„ҸгҖӮжҜ”еҰӮ AI дҪҝз”ЁдәҶйҒҺжҷӮзҡ„иіҮиЁҠпјҢжҲ–иҖ…жҲ‘еҖ‘е°ҚжңҖиҝ‘жүҚжҺЁеҮәзҡ„еҠҹиғҪжҸҗеҮәе•ҸйЎҢгҖӮдҪҶеҖјеҫ—ж…¶е№ёзҡ„жҳҜпјҢйҖҷдәӣ AI еҸҜд»Ҙеӯёзҝ’пјҢиҖҢжҲ‘еҖ‘еҸҜд»ҘжҸҗдҫӣ幫еҠ©гҖӮжҲ‘еҖ‘еҸҜд»ҘдҪҝз”Ёйҷҗе®ҡзҜ„еңҚзҡ„ијёе…ҘдҫҶиЁ“з·ҙйҖҷдәӣжЁЎеһӢпјҢдёҰйҖЈжҺҘеӨ–жҺӣзЁӢејҸпјҢд»ҘдҫҝеңЁдҪҝз”Ё Cloudflare жңҚеӢҷжҷӮзӮәжҲ‘еҖ‘зҡ„е®ўжҲ¶жҸҗдҫӣжӣҙеҘҪзҡ„ AI еј•е°Һй«”й©—гҖӮ

жҲ‘еҖ‘зһӯи§ЈеҲ°жңүдёҖдәӣе®ўжҲ¶жғіиҰҒеҹ·иЎҢзӣёеҗҢзҡ„ж“ҚдҪңпјҢеғҸжҲ‘еҖ‘дёҖжЁЈпјҢд»–еҖ‘йңҖиҰҒе®үе…Ёең°еҲҶдә«иЁ“з·ҙиіҮж–ҷпјҢдёҰжҺҲдәҲ AI жңҚеӢҷеӨ–жҺӣзЁӢејҸеӯҳеҸ–ж¬ҠгҖӮCloudflare One зҡ„е®үе…ЁеҘ—件超и¶ҠдәҶдәәйЎһдҪҝз”ЁиҖ…зҡ„зҜ„еңҚпјҢдҪҝеңҳйҡҠиғҪйҖҸйҒҺ API е®үе…Ёең°еҲҶдә«е°Қж•Ҹж„ҹжҖ§иіҮж–ҷзҡ„ Zero Trust еӯҳеҸ–гҖӮ

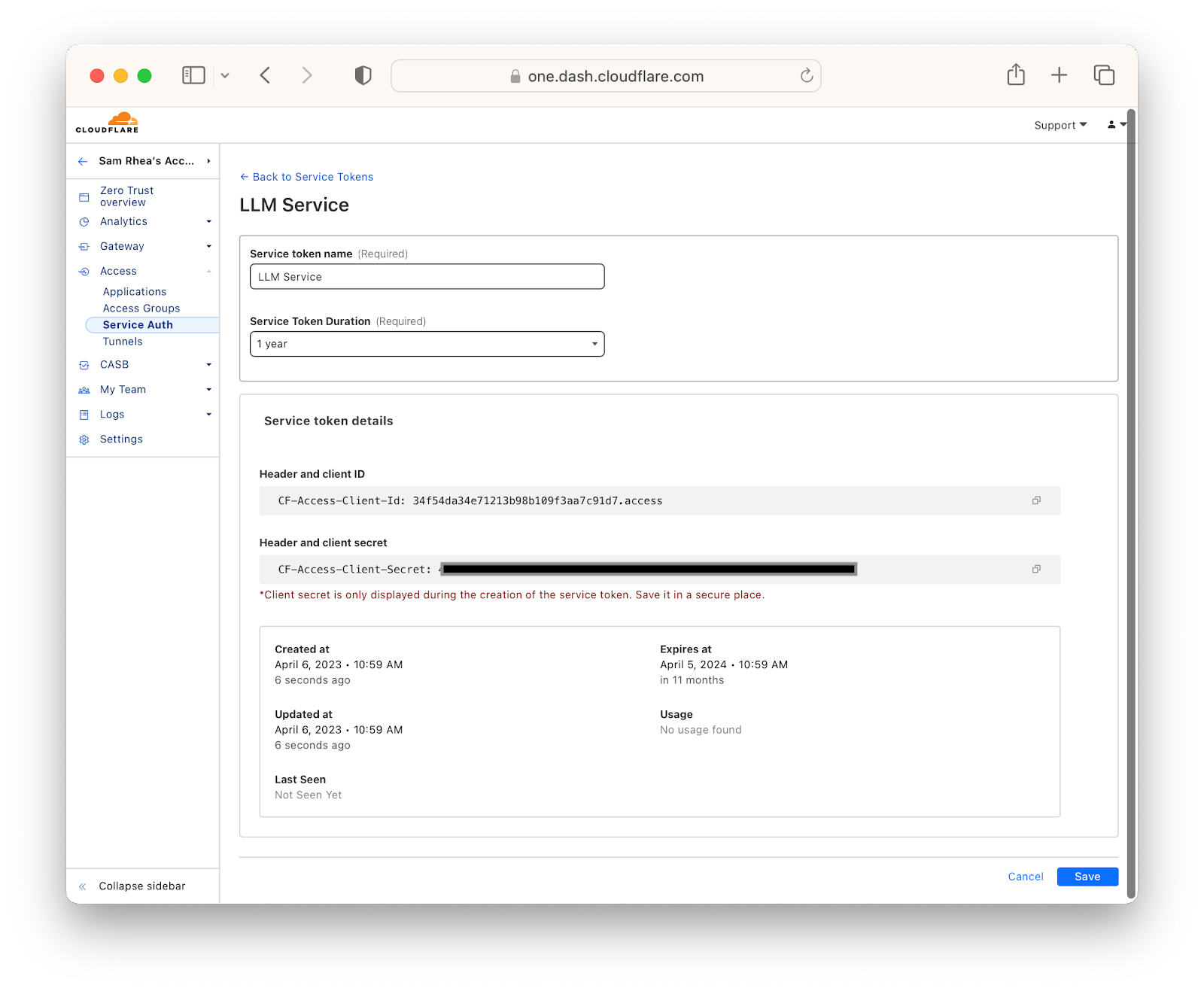

йҰ–е…ҲпјҢеңҳйҡҠеҸҜд»Ҙе»әз«ӢжңҚеӢҷж¬Ҡжқ–пјҢеӨ–йғЁжңҚеӢҷеҝ…й ҲжҸҗдҫӣи©ІжңҚеӢҷж¬Ҡжқ–жүҚиғҪеӯҳеҸ–йҖҸйҒҺ Cloudflare One жҸҗдҫӣзҡ„иіҮж–ҷгҖӮз®ЎзҗҶе“ЎеҸҜд»Ҙеҗ‘йҖІиЎҢ API и«ӢжұӮзҡ„зі»зөұжҸҗдҫӣйҖҷдәӣж¬Ҡжқ–пјҢдёҰиЁҳйҢ„жҜҸеҖӢи«ӢжұӮгҖӮеҰӮжңүйңҖиҰҒпјҢеңҳйҡҠеҸӘйңҖжҢүдёҖдёӢеҚіеҸҜж’ӨйҠ·йҖҷдәӣж¬Ҡжқ–гҖӮ

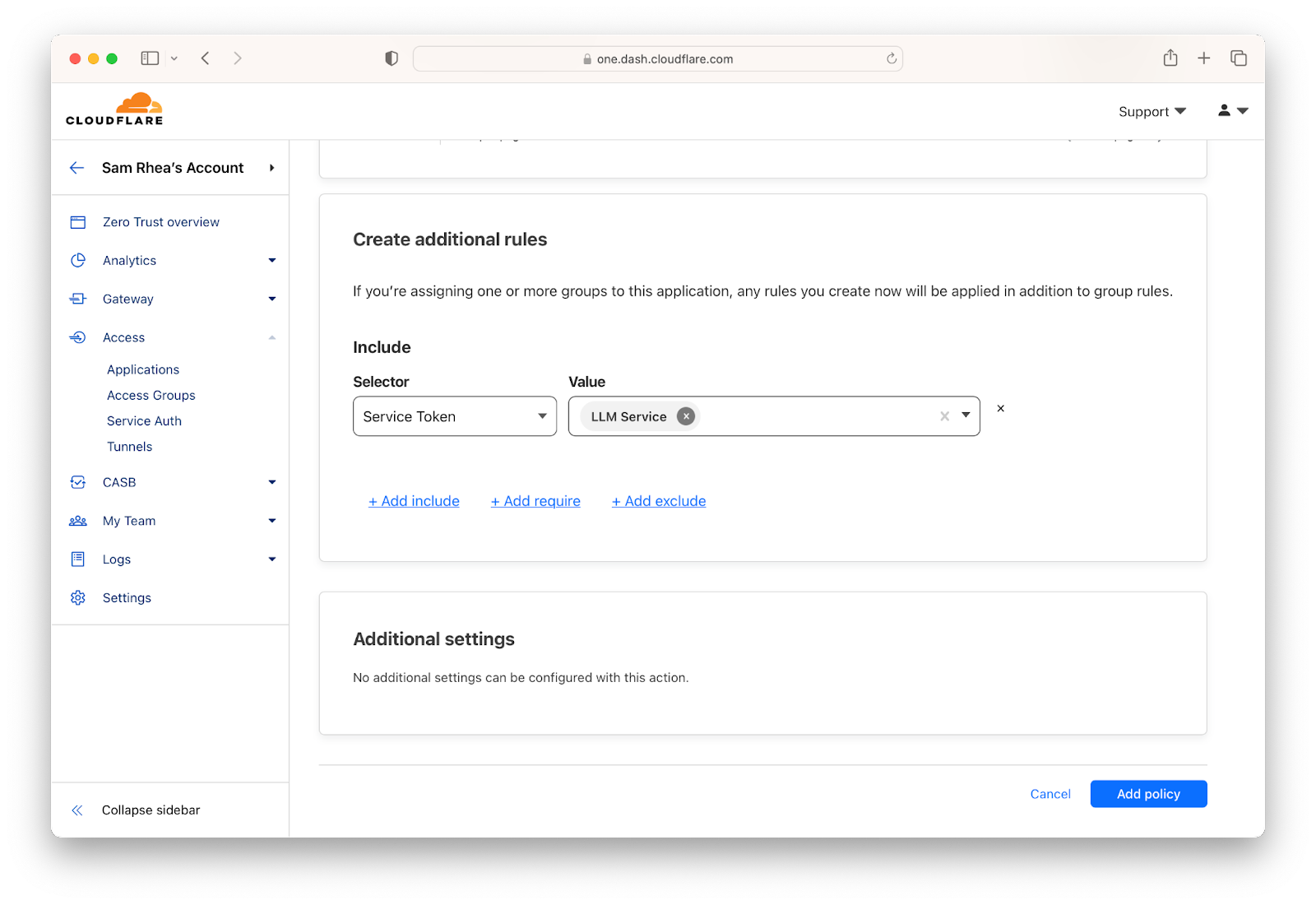

е»әз«ӢдёҰз°ҪзҷјжңҚеӢҷж¬Ҡжқ–еҫҢпјҢз®ЎзҗҶе“ЎеҸҜд»Ҙе»әз«ӢеҺҹеүҮд»Ҙе…ҒиЁұзү№е®ҡжңҚеӢҷеӯҳеҸ–е…¶иЁ“з·ҙиіҮж–ҷгҖӮйҖҷдәӣеҺҹеүҮе°Үй©—иӯүжңҚеӢҷж¬Ҡжқ–пјҢдёҰеҸҜд»Ҙж“ҙеұ•д»Ҙй©—иӯүеңӢ家/ең°еҚҖгҖҒIP дҪҚеқҖжҲ– mTLS жҶ‘иӯүгҖӮжӮЁд№ҹеҸҜд»Ҙе»әз«ӢеҺҹеүҮпјҢиҰҒжұӮдәәйЎһдҪҝз”ЁиҖ…еҗ‘иӯҳеҲҘжҸҗдҫӣиҖ…йҖІиЎҢй©—иӯүпјҢдёҰеңЁеӯҳеҸ–ж•Ҹж„ҹиЁ“з·ҙиіҮж–ҷжҲ–жңҚеӢҷд№ӢеүҚе®ҢжҲҗ MFA жҸҗзӨәгҖӮ

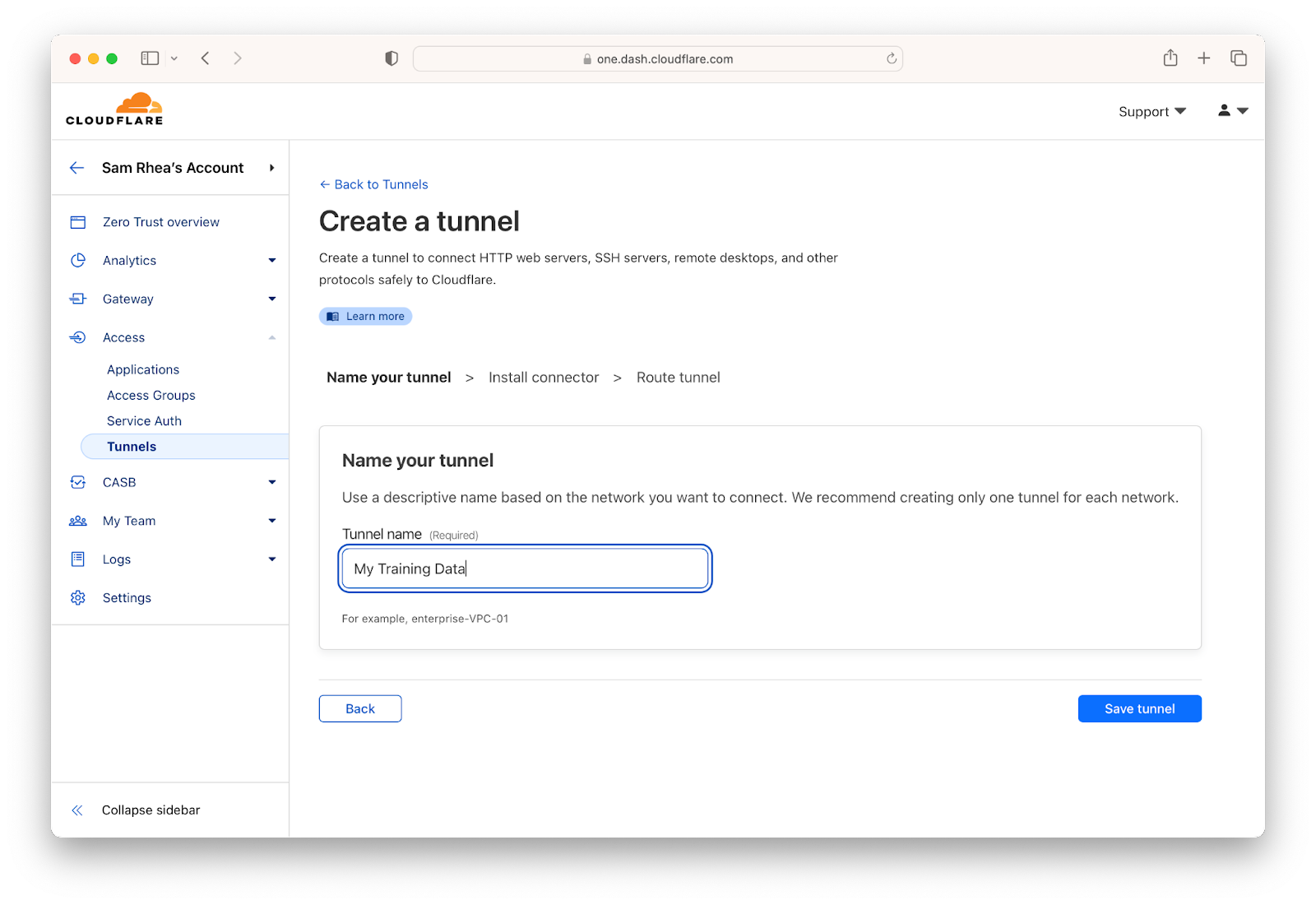

當еңҳйҡҠжә–еӮҷеҘҪе…ҒиЁұ AI жңҚеӢҷйҖЈжҺҘеҲ°е…¶еҹәзӨҺзөҗж§ӢжҷӮпјҢд»–еҖ‘еҸҜд»ҘдҪҝз”Ё Cloudflare Tunnel дҫҶеҜҰзҸҫйҖҷдёҖй»һпјҢиҖҢз„ЎйңҖеңЁйҳІзҒ«зүҶдёӯйҖ жҲҗжјҸжҙһгҖӮCloudflare Tunnel е°Үе»әз«ӢиҲҮ Cloudflare з¶Іи·Ҝзҡ„еҠ еҜҶгҖҒеғ…йҷҗијёеҮәйҖЈз·ҡпјҢдёҰе°Үж №ж“ҡзӮә Cloudflare One дҝқиӯ·зҡ„дёҖй …жҲ–еӨҡй …жңҚеӢҷиЁӯе®ҡзҡ„еӯҳеҸ–иҰҸеүҮжӘўжҹҘжҜҸеҖӢи«ӢжұӮгҖӮ

еҲ©з”Ё Cloudflare зҡ„ Zero Trust еӯҳеҸ–жҺ§еҲ¶пјҢжӮЁиғҪеӨ е°Қзө„з№”жұәе®ҡеҗ‘йҖҷдәӣе·Ҙе…·жҸҗдҫӣзҡ„иіҮж–ҷзҷјеҮәзҡ„жҜҸеҖӢи«ӢжұӮеј·еҲ¶йҖІиЎҢй©—иӯүгҖӮйҖҷд»Қ然з•ҷдёӢдәҶдёҖеҖӢжјҸжҙһпјҢжӮЁзҡ„еңҳйҡҠжҲҗе“ЎеҸҜиғҪжңғиҮӘе·ұйҒҺеәҰеҲҶдә«иіҮж–ҷгҖӮ

йҷҗеҲ¶иіҮж–ҷдёҠеӮі

з®ЎзҗҶе“ЎеҸҜд»ҘйҒёж“Ү AI жңҚеӢҷгҖҒе°ҒйҺ–еҪұеӯҗ ITжӣҝд»Је·Ҙе…·пјҢдёҰе°Ҹеҝғең°жҺ§еҲ¶е°Қе…¶иЁ“з·ҙжқҗж–ҷзҡ„еӯҳеҸ–пјҢдҪҶдәәйЎһд»Қ然еҸғиҲҮйҖҷдәӣ AI еҜҰй©—гҖӮжҲ‘еҖ‘д»»дҪ•дәәйғҪеҸҜиғҪжңғеңЁдҪҝз”Ё AI жңҚеӢҷпјҲз”ҡиҮіжҳҜз¶“ж ёеҮҶзҡ„жңҚеӢҷпјүзҡ„йҒҺзЁӢдёӯйҒҺеәҰеҲҶдә«иіҮиЁҠиҖҢж„ҸеӨ–е°ҺиҮҙе®үе…ЁдәӢ件гҖӮ

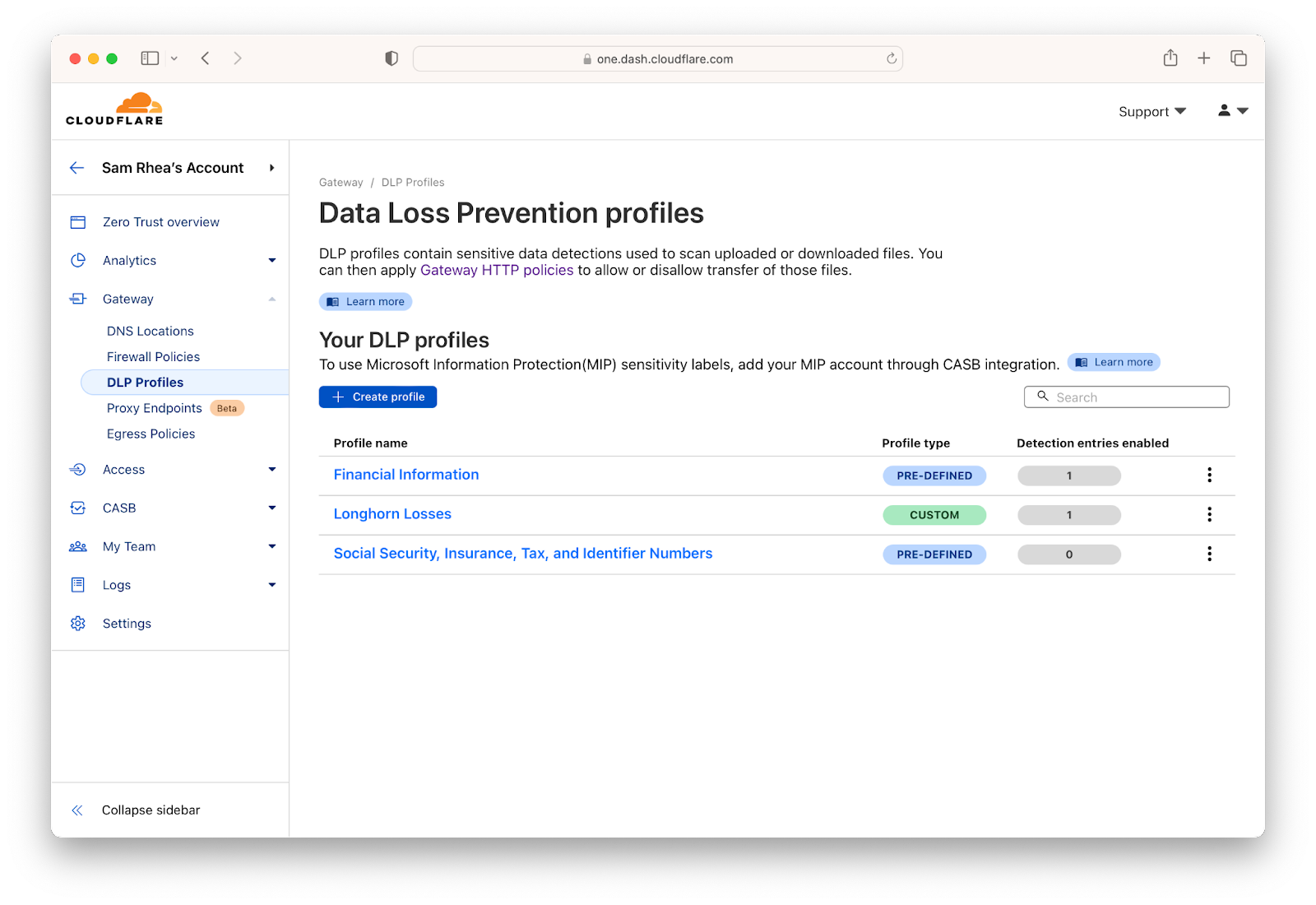

жҲ‘еҖ‘й җиЁҲ AI й ҳеҹҹе°Үз№јзәҢзҷјеұ•пјҢд»ҘжҸҗдҫӣжӣҙеӨҡиіҮж–ҷз®ЎзҗҶеҠҹиғҪпјҢдҪҶжҲ‘еҖ‘иӘҚзӮәжӮЁдёҚеҝ…зӯүеҲ°йӮЈеҖӢжҷӮеҖҷжүҚй–Ӣе§ӢжҺЎз”ЁйҖҷдәӣжңҚеӢҷдҪңзӮәе·ҘдҪңжөҒзЁӢзҡ„дёҖйғЁеҲҶгҖӮCloudflare зҡ„ Data Loss Prevention (DLP) жңҚеӢҷеҸҜд»ҘжҸҗдҫӣдҝқиӯ·жҺӘж–ҪпјҢйҳ»жӯўйҒҺеәҰеҲҶдә«пјҢйҒҝе…Қе…¶жҲҗзӮәйңҖиҰҒе®үе…ЁеңҳйҡҠиҷ•зҗҶзҡ„дәӢ件гҖӮ

йҰ–е…ҲпјҢе‘ҠиЁҙ Cloudflare жӮЁй—ңеҝғе“ӘдәӣиіҮж–ҷгҖӮCloudflare жҸҗдҫӣз°Ўе–®гҖҒй җе…ҲиЁӯе®ҡзҡ„йҒёй …пјҢи®“жӮЁиғҪеӨ жӘўжҹҘзңӢиө·дҫҶеғҸиә«еҲҶиӯүиҷҹзўјжҲ–дҝЎз”ЁеҚЎиҷҹзўјзҡ„е…§е®№гҖӮCloudflare DLP йӮ„еҸҜд»Ҙж №ж“ҡжӮЁзҡ„еңҳйҡҠиЁӯе®ҡзҡ„иҰҸеүҮйҒӢз®—ејҸжҺғжҸҸжЁЎејҸгҖӮ

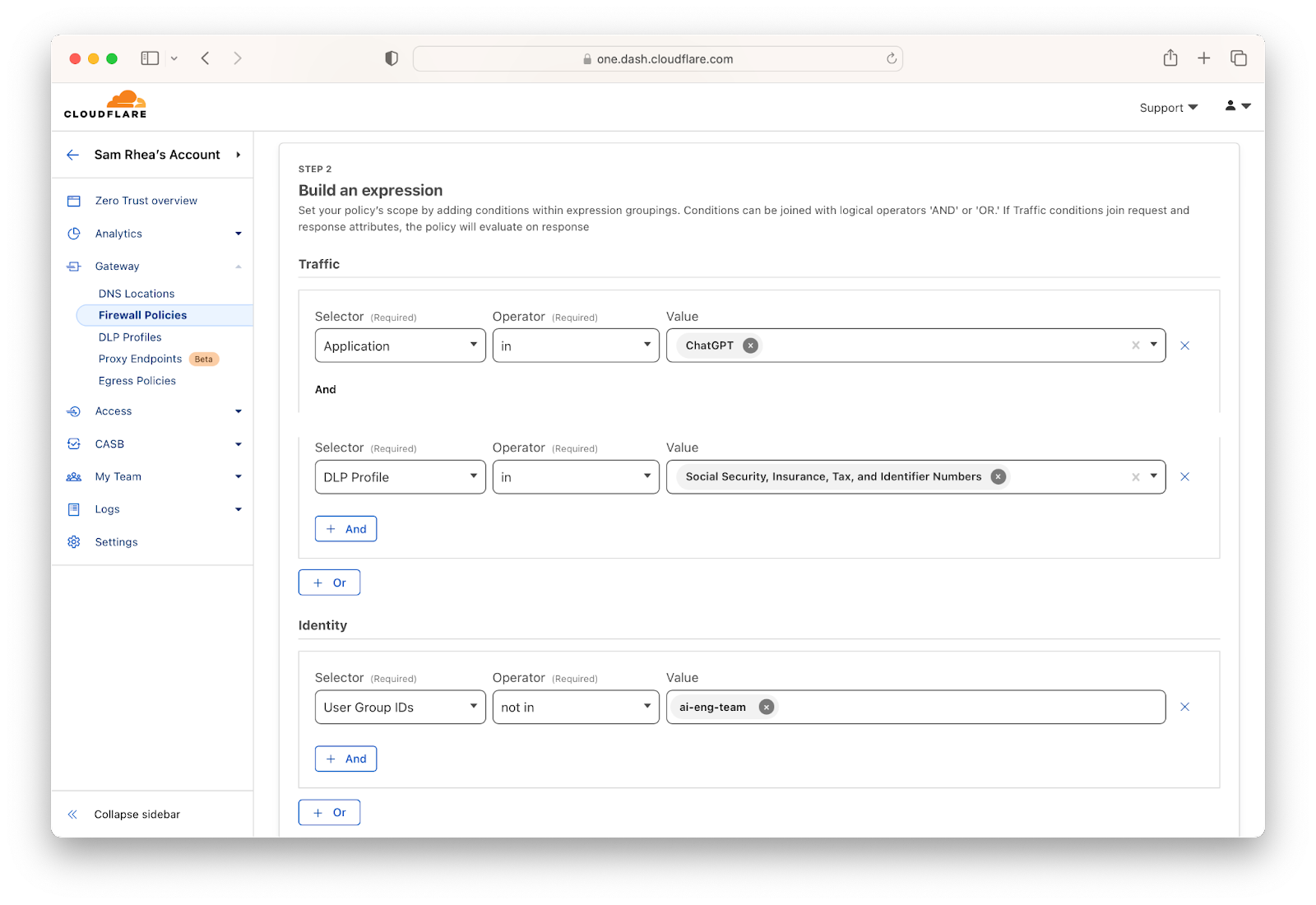

еңЁе®ҡзҫ©дёҚеҫ—йӣўй–Ӣзө„з№”зҡ„иіҮж–ҷеҫҢпјҢжӮЁе°ұеҸҜд»Ҙе»әз«Ӣи©ізҙ°иҰҸеүҮпјҢиҰҸе®ҡеҸҜд»ҘеҰӮдҪ•иҲҮ AI жңҚеӢҷеҲҶдә«иіҮж–ҷпјҢд»ҘеҸҠдёҚиғҪеҰӮдҪ•иҲҮ AI жңҚеӢҷеҲҶдә«иіҮж–ҷгҖӮд№ҹиЁұжҹҗдәӣдҪҝз”ЁиҖ…иў«ж ёеҮҶеҳ—и©ҰеҢ…еҗ«ж•Ҹж„ҹжҖ§иіҮж–ҷзҡ„е°ҲжЎҲпјҢеңЁйҖҷзЁ®жғ…жіҒдёӢпјҢжӮЁеҸҜд»Ҙж§Ӣе»әдёҖжўқиҰҸеүҮпјҢеғ…е…ҒиЁұ Active Directory жҲ– Okta зҫӨзө„дёҠеӮіжӯӨйЎһиіҮиЁҠпјҢиҖҢе…¶д»–дәәеүҮиў«е°ҒйҺ–гҖӮ

з„ЎйңҖд»ЈзҗҶеҚіеҸҜжҺ§еҲ¶дҪҝз”Ё

йҖҷзҜҮж–Үз« дёӯзҡ„е·Ҙе…·и‘—йҮҚж–јйҒ©з”Ёж–јеӢ•ж…ӢиіҮж–ҷзҡ„еҠҹиғҪгҖӮжҲ‘еҖ‘йӮ„еёҢжңӣзўәдҝқжҮүз”ЁзЁӢејҸдёӯзҡ„йҢҜиӘӨиЁӯе®ҡдёҚжңғе°ҺиҮҙе®үе…ЁйҒ•иҰҸгҖӮдҫӢеҰӮпјҢChatGPT дёӯзҡ„ж–°еӨ–жҺӣзЁӢејҸеҠҹиғҪе°ҮеӨ–йғЁжңҚеӢҷзҡ„зҹҘиӯҳе’Ңе·ҘдҪңжөҒзЁӢеё¶е…Ҙ AI дә’еӢ•жөҒзЁӢдёӯгҖӮдҪҶжҳҜпјҢйҖҷд№ҹеҸҜиғҪе°ҺиҮҙеӨ–жҺӣзЁӢејҸиғҢеҫҢзҡ„жңҚеӢҷе…·жңүзҡ„еӯҳеҸ–ж¬Ҡйҷҗи¶…еҮәжӮЁжғіиҰҒжҺҲдәҲзҡ„ж¬ҠйҷҗгҖӮ

Cloudflare зҡ„йӣІз«ҜеӯҳеҸ–е®үе…ЁжҖ§д»ЈзҗҶзЁӢејҸ (CASB) жңғжҺғжҸҸжӮЁзҡ„ SaaS жҮүз”ЁзЁӢејҸпјҢд»ҘжҹҘжүҫдҪҝз”ЁиҖ…йҖІиЎҢи®ҠжӣҙжҷӮеҸҜиғҪеҮәзҸҫзҡ„жҪӣеңЁе•ҸйЎҢгҖӮз„Ўи«–жҳҜе°ұжңүдәәж„ҸеӨ–еңЁз¶Ійҡӣз¶Іи·ҜдёҠе…¬й–ӢжӘ”жЎҲиҖҢеҗ‘жӮЁзҷјеҮәжҸҗзӨәпјҢйӮ„жҳҜжӘўжҹҘжӮЁзҡ„ GitHub еӯҳж”ҫеә«жҳҜеҗҰе…·жңүжӯЈзўәзҡ„жҲҗе“ЎиіҮж јжҺ§еҲ¶пјҢCloudflare зҡ„ CASB йғҪж¶ҲйҷӨдәҶжӘўжҹҘ SaaS жҮүз”ЁзЁӢејҸдёӯжҜҸй …иЁӯе®ҡжҳҜеҗҰеӯҳеңЁжҪӣеңЁе•ҸйЎҢжүҖйңҖзҡ„жүӢеӢ•е·ҘдҪңгҖӮ

CloudflareжӯЈеңЁеҠӘеҠӣиҲҮзҶұй–Җзҡ„ AI жңҚеӢҷйҖІиЎҢж–°зҡ„ж•ҙеҗҲпјҢд»ҘжӘўжҹҘйҢҜиӘӨиЁӯе®ҡпјҢйҖҷдәӣж•ҙеҗҲеҚіе°ҮжҺЁеҮәгҖӮ

зөҗиӘһ

йҖҷдәӣе·Ҙе…·зҡ„еҜҰз”ЁжҖ§еҸӘжңғеҠ еҝ«гҖӮAI жңҚеӢҷе’Ңз”ўз”ҹијёеҮәзҡ„иғҪеҠӣе°Үз№јзәҢдҪҝд»»дҪ•иғҢжҷҜзҡ„ж§Ӣе»әиҖ…жӣҙе®№жҳ“еүөйҖ еҮәдёӢдёҖеҖӢеҒүеӨ§зҡ„дҪңе“ҒгҖӮCloudflare з”ўе“Ғе°Ҳ注於幫еҠ©дҪҝз”ЁиҖ…ж§Ӣе»әжҮүз”ЁзЁӢејҸе’ҢжңҚеӢҷпјҢ и®“дҪҝз”ЁиҖ…з„ЎйңҖж“”еҝғеңЁе“ӘиЈЎйғЁзҪІжҮүз”ЁзЁӢејҸжҲ–еҰӮдҪ•ж“ҙеұ•жңҚеӢҷгҖӮCloudflare и§ЈжұәдәҶйҖҷдәӣд»Өдәәй ӯз–јзҡ„е•ҸйЎҢпјҢи®“дҪҝз”ЁиҖ…еҸҜд»Ҙе°ҲжіЁж–јеүөдҪңгҖӮиҲҮ AI жңҚеӢҷзӣёзөҗеҗҲпјҢCloudflare й җиЁҲе°Үжңүж•ёеҚғеҗҚж–°ж§Ӣе»әиҖ…жҺЁеҮәеҹәж–ј Cloudflare дёҰеҸ—еҲ° AI жҢҮе°Һе’Ңз”ўз”ҹе•ҹзҷјзҡ„дёӢдёҖжіўз”ўе“ҒгҖӮ

зӣ®еүҚ已經зңӢеҲ°дҪҝз”Ё ChatGPT зӯүе·Ҙе…·еңЁ Cloudflare Workers дёҠж§Ӣе»әзҡ„ж•ёеҚҒеҖӢе°ҲжЎҲ蓬еӢғзҷјеұ•гҖӮCloudflare иЁҲеҠғжҺЁеҮәиҲҮйҖҷдәӣжЁЎеһӢзҡ„ж–°ж•ҙеҗҲпјҢдҪҝд№ӢжӣҙеҠ й ҶжҡўпјҢзӮәе°Қи©ұй«”й©—её¶дҫҶжӣҙеҘҪзҡ„ Cloudflare зү№е®ҡжҢҮеј•гҖӮ